AI大模型“概念地图”首次构建,开辟认知科学新路径

AI导读:

中国科学院团队结合行为实验与神经影像分析,首次证实多模态大语言模型能自发形成与人类相似的物体概念表征系统,构建AI大模型的“概念地图”,为人工智能认知科学开辟新路径。

近日,中国科学院自动化研究所神经计算与脑机交互(NeuBCI)课题组与中国科学院脑科学与智能技术卓越创新中心的联合团队,结合行为实验与神经影像分析,首次证实多模态大语言模型(MLLMs)能自发形成与人类相似的物体概念表征系统,为人工智能认知科学开辟新路径,为构建类人认知结构的人工智能系统提供理论框架。相关研究成果已发表于《自然·机器智能》。

该研究首次构建AI大模型的“概念地图”

人类能对自然界物体进行概念化,这一能力被视为人类智能核心。当我们看到“狗”“汽车”或“苹果”时,不仅识别物理特征,还理解功能、情感价值和文化意义,构成人类认知基石。随着ChatGPT等大语言模型(LLMs)发展,根本性问题浮现:能否从语言和多模态数据中发展出类似人类物体概念表征?

传统人工智能研究聚焦物体识别准确率,却少探讨模型是否真正“理解”物体。论文通讯作者何晖光研究员指出,当前AI能区分猫狗图片,但“识别”与人类“理解”本质区别仍有待揭示。

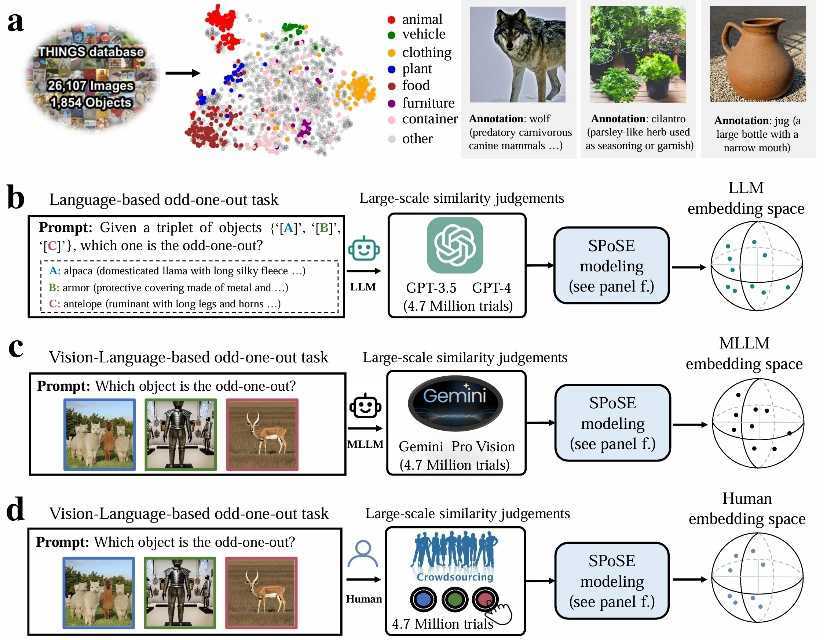

团队从认知神经科学出发,设计融合计算建模、行为实验与脑科学的创新范式,采用认知心理学“三选一异类识别任务”,要求大模型与人类从物体概念三元组(来自1854种日常概念组合)中选出最不相似的选项。通过分析470万次行为判断数据,团队首次构建AI大模型“概念地图”。

实验范式示意图显示物体概念集及带有语言描述的图像示例,以及针对LLM、MLLM和人类的行为实验范式和概念嵌入空间。

研究发现,AI“心智维度”与人类相似。从海量大模型行为数据中提取66个“心智维度”,并赋予语义标签。这些维度高度可解释,且与大脑类别选择区域神经活动模式显著相关。研究还对比模型行为选择模式与人类一致性,显示多模态大模型表现更优。

本研究表明,大语言模型内部存在类似人类对现实世界概念的理解,并非“随机鹦鹉”。

论文第一作者为自动化所副研究员杜长德,通讯作者为何晖光研究员。主要合作者包括脑智卓越中心常乐研究员等。研究得到中国科学院基础与交叉前沿科研先导专项、国家自然科学基金等资助。

(文章来源:上观新闻)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。