DeepSeek FP8技术引爆AI算力革命,国产芯片加速崛起

AI导读:

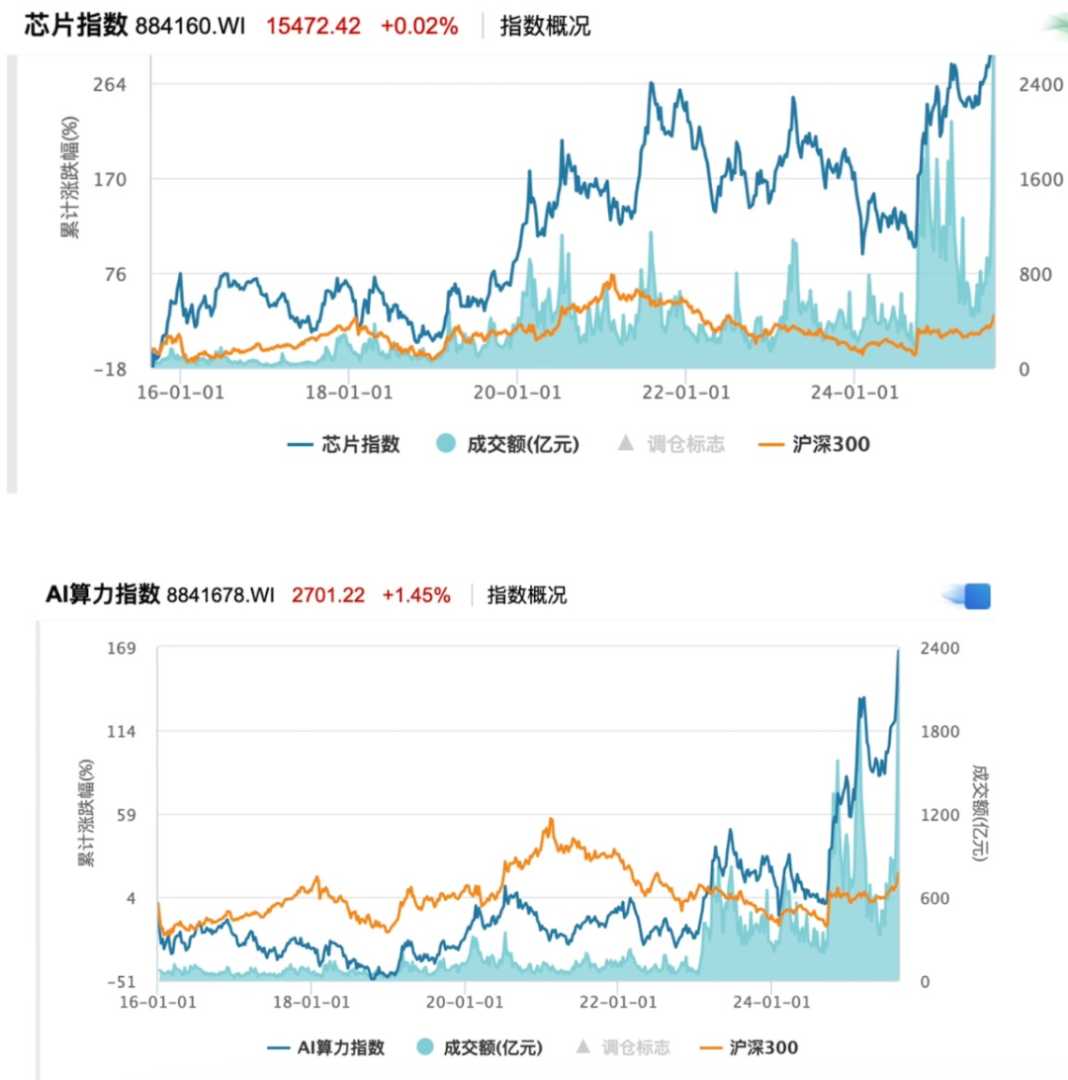

8月26日,芯片指数与AI算力指数持续走高,DeepSeek发布DeepSeek-V3.1,使用UE8M0 FP8 Scale参数精度,引发低精度计算热潮。FP8技术经历三年成长,逐渐被行业接纳,推动产业链厂商在低精度领域布局。国产AI芯片产业争夺主导权,中国AI加速卡国产份额预计年底过半。

8月26日,芯片指数(884160.WI)探底回升,午盘涨0.02%,近一个月涨19.5%;AI算力指数(8841678.WI)热度延续,午盘涨1.45%,近一个月涨22.47%。消息面上,Deepseek上周发布DeepSeek-V3.1,称此次升级是迈向Agent(智能体)时代的第一步,使用了UE8M0 FP8 Scale参数精度,并表示UE8M0 FP8是针对即将发布的下一代国产芯片而设计,此举精准切中AI行业对高效低功耗计算的迫切需求,引发低精度计算热潮,为国产算力赛道再添一把火。

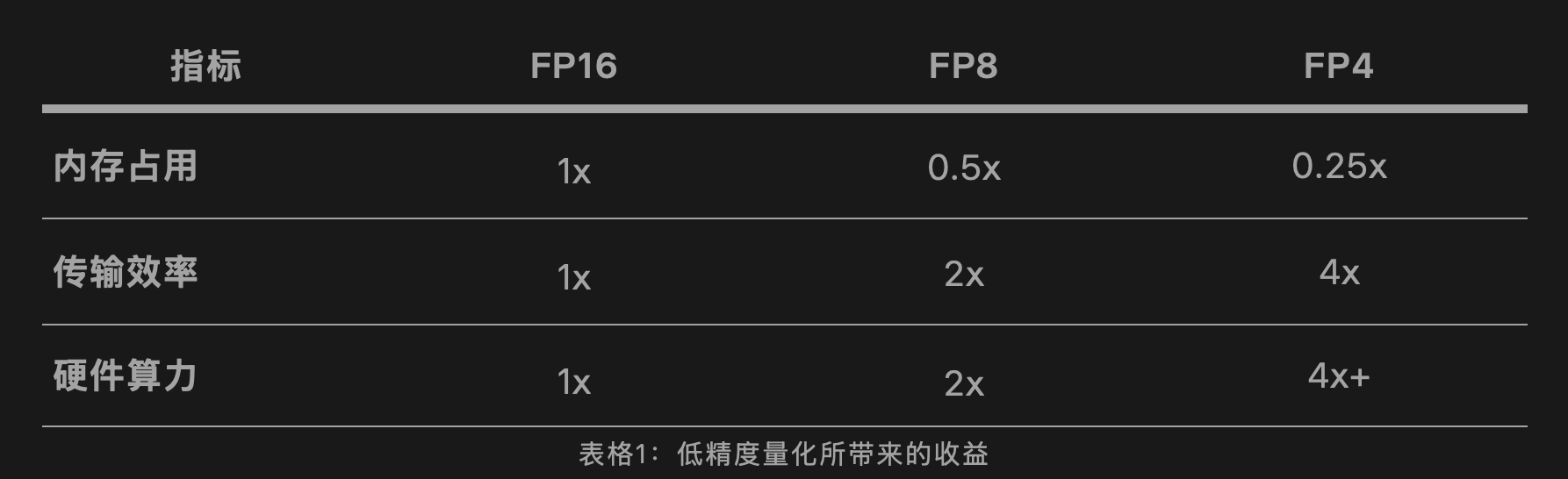

芯片指数与AI算力指数近期持续走高,背后是AI浪潮与大模型算力需求剧增下,国产替代加速与供应链多元化路径日渐成熟的趋势。爆火前的三年成长期:FP8作为8位浮点数格式,早在2022年9月英伟达即预告Hopper架构的H100 GPU将原生支持FP8,但因涉及全产业链环节,直到2023年GPT-4与Llama-2验证FP16够用后,FP8才逐渐被行业接纳。2023年,OCP发布《MX规范》第一版本,将FP8包装为MXFP8,保障稳定性。2024年,行业出现万卡集群、推理爆发,FP8逐渐被更多厂商关注并布局。2024年12月,DeepSeek通过V3模型跑通MXFP8,意味着在复杂的AI训练任务中,MXFP8可以高效发挥作用,吸引众多AI开发者、研究机构与相关企业的关注。

从MXFP8到UE8M0 FP8,行业内编码方式、动态范围、硬件处理、应用场景和生态发展均发生了升级迭代,更加聚焦大语言模型训练等场景,在处理Transformer架构中长尾分布的权重时表现良好。但趋势上,两者均归属于FP8类别,体现了低精度计算在提升效率上的优势,推动产业链厂商在低精度领域布局。宏微观因素双轮驱动:近期,借DeepSeek“东风”,二级市场多家芯片公司与券商机构密集披露FP8布局与解读,背后既有技术因素影响,更是国产AI芯片产业争夺产业主导权的趋势驱动。据财通证券研报,2025年第二季度国产芯片市占率提升至38.7%。

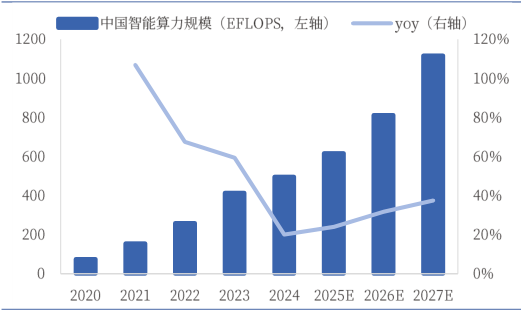

此前,工信部印发《算力互联互通行动计划》,提出到2026年,建立完备的算力互联互通标准、标识和规则体系;到2028年,基本实现全国公共算力标准化互联。行业侧,AI领域已进入低精度计算时代,模型低精度量化能够同时有效应对计算量大、储存不足和数据传输慢这三个问题。爱芯元智相关负责人表示,FP8的混合精度训练框架将推动算力厂商调整技术路线,多精度混合架构可同时运行FP32、FP16与FP8任务,训练效率较传统方案显著提升。曦望联席CEO王湛表示,大模型推理对低精度数字的计算量需求极大,聚焦推理场景的芯片需重点强化低精度计算能力。精度替换部分进行中:虽然低精度将会是业界普遍追求的方向,但这一趋势并非没有边界。王湛表示,低精度并非可以无限追求,当精度过低(如低于FP4),数据可能会因为失真而无法承载大模型所需的信息。爱芯元智相关负责人也认为,FP8的落地需芯片、框架、算子全链路适配。摩尔线程副总裁王华也在此前的分享中强调,精度替换只能部分进行,无法完全替代,精度敏感的环节仍需保留高精度计算。壁仞研究院预测,随着低精度训练方法的成熟和更多芯片在硬件上对低比特格式的支持,大模型的训练时间将大幅缩短。财通证券引用IDC数据分析称,受宏观因素影响,中国AI加速卡国产份额已由2023年的不足15%提升至2025年上半年的40%以上,预计年底将过半。

(文章来源:第一财经)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。