DeepSeek开源周收官,揭秘AI推理系统成本与利润率

AI导读:

DeepSeek开源周收官,发布《DeepSeek-V3/R1 推理系统概览》文章,揭秘AI推理系统成本与利润率,假定GPU租赁成本为2美元/小时,DeepSeek理论成本利润率高达545%。

Deepseek开源周收官,DeepSeek以最后一弹,再次在AI领域激起了广泛关注。

3月1日,DeepSeek在知乎上发表题为《DeepSeek-V3/R1 推理系统概览》的文章,全面揭晓了V3/R1 推理系统的核心秘密。

尤为引人注目的是,文章首次披露了DeepSeek的理论成本和利润率等关键信息。据悉,假定GPU租赁成本为2美元/小时,DeepSeek的总成本为87072美元/天;若所有tokens均按DeepSeek R1的定价计算,其理论日收入可达562027美元,成本利润率高达545%。

优化推理系统,DeepSeek实现545%的成本利润率

据文章透露,DeepSeek-V3/R1推理系统的优化目标是提升吞吐、降低延迟。为实现这些目标,DeepSeek采用了大规模跨节点专家并行(Expert Parallelism / EP)的方法,并通过一系列技术策略,最大限度地优化了大模型推理系统,取得了卓越的性能和效率。

具体而言,在提升吞吐方面,大规模跨节点专家并行能够显著增加batch size,从而提高GPU矩阵乘法的效率,提升吞吐能力。

batch size在深度学习中至关重要,它决定了每次模型更新时使用的训练样本数量。调整batch size会影响模型的训练速度、内存消耗以及模型权重的更新方式。

在降低延迟方面,大规模跨节点专家并行使得专家分散在不同的GPU上,每个GPU仅需计算少量专家(因此减少访存需求),从而降低延迟。

然而,大规模跨节点专家并行也大幅增加了系统的复杂性,带来了跨节点通信、多节点数据并行、负载均衡等挑战。因此,DeepSeek在文章中也着重阐述了如何使用大规模跨节点专家并行增大batch size,同时隐藏传输耗时,实现负载均衡。

具体而言,DeepSeek团队通过规模化跨节点专家并行、双批次重叠策略、最优负载均衡等方式,最大化资源利用率,确保高性能和稳定性。

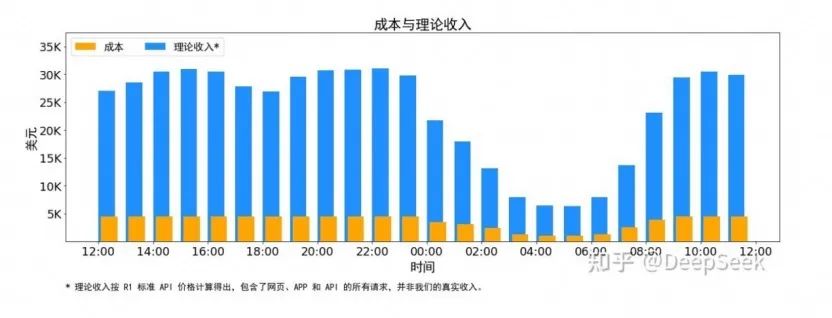

值得注意的是,文章还披露了DeepSeek的理论成本和利润率等关键信息。DeepSeek V3 和R1的所有服务均使用英伟达的H800 GPU。由于服务负荷存在昼夜差异,DeepSeek实现了一套机制,在白天负荷高时,使用所有节点部署推理服务;晚上负荷低时,减少推理节点,用于研究和训练。

通过时间上的成本控制,DeepSeek V3和R1推理服务占用的节点总和,峰值占用为278个节点,平均占用226.75个节点(每个节点为8个H800 GPU)。假定GPU租赁成本为2美元/小时,总成本为87072美元/天;若所有tokens均按DeepSeek R1的定价计算,理论日收入为562027美元,成本利润率为545%。

不过,DeepSeek也指出,实际收入可能低于此数,因为V3的定价相较于R1更低,且夜间还有折扣。2月26日,DeepSeek在其API开放平台发布错峰优惠活动通知。根据通知,北京时间每日00:30-08:30为错峰时段,API调用价格大幅下调。

随着最后一枚“重磅炸弹”的发布,DeepSeek的开源周活动正式结束。

在过去的一周里,DeepSeek每天开源一个代码库,堪称公开了一个“技术全家桶”。业内人士分析,这一系列技术组件看似独立,实则共同构建了一套精密协同的系统,让DeepSeek在有限算力下最大限度地发挥了GPU的性能,实现了训练推理效率的大幅提升。

(文章来源:证券时报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。