AI深度合成音视频侵权频发,专家呼吁加强监管

AI导读:

过去一年,AI深度合成音视频侵权现象愈演愈烈,网店利用AI技术制作名人音视频牟利,已属侵权行为。专家呼吁加强法律监管,利用AI技术对抗检测AI,提高公众安全风险意识。

从恶搞企业家雷军到AI制作张文宏医生音视频为自己带货,过去一年,AI深度合成音视频侵权现象愈演愈烈。AI技术的滥用不仅侵犯了名人的肖像权和声音权,也给普通网民带来了潜在的风险。

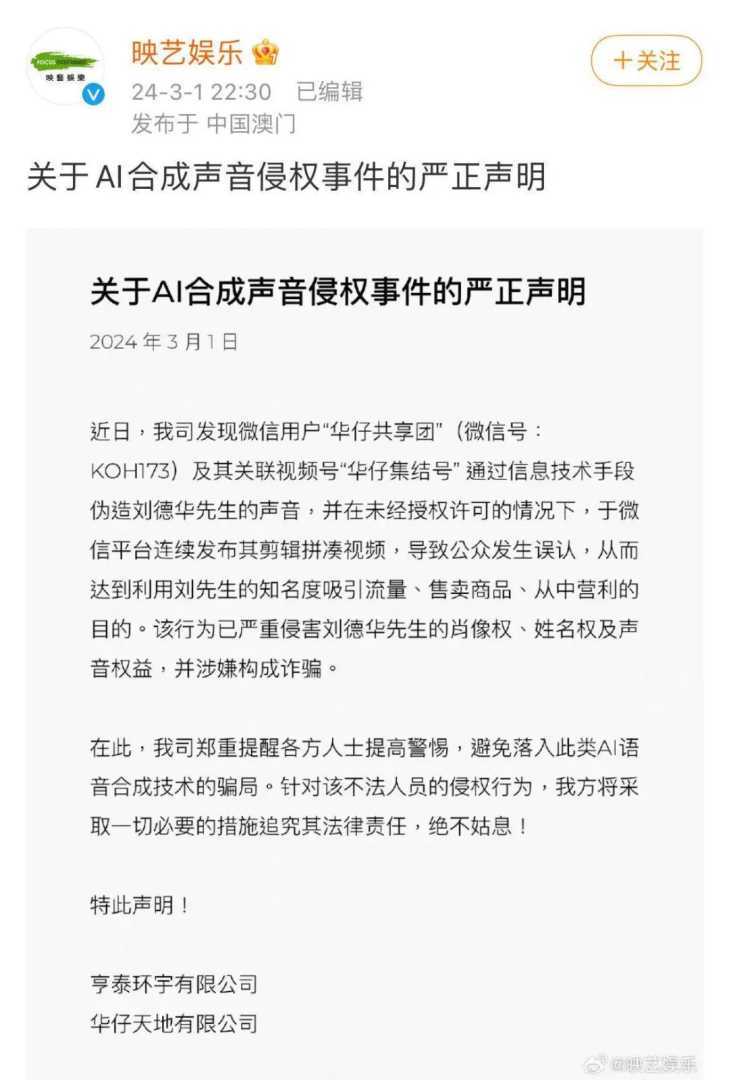

此前,有网友曾利用AI制作的刘德华声音为自己博取流量,刘德华电影公司紧急发布声明,提醒网民不要落入伪造刘德华声音的AI语音合成技术骗局。

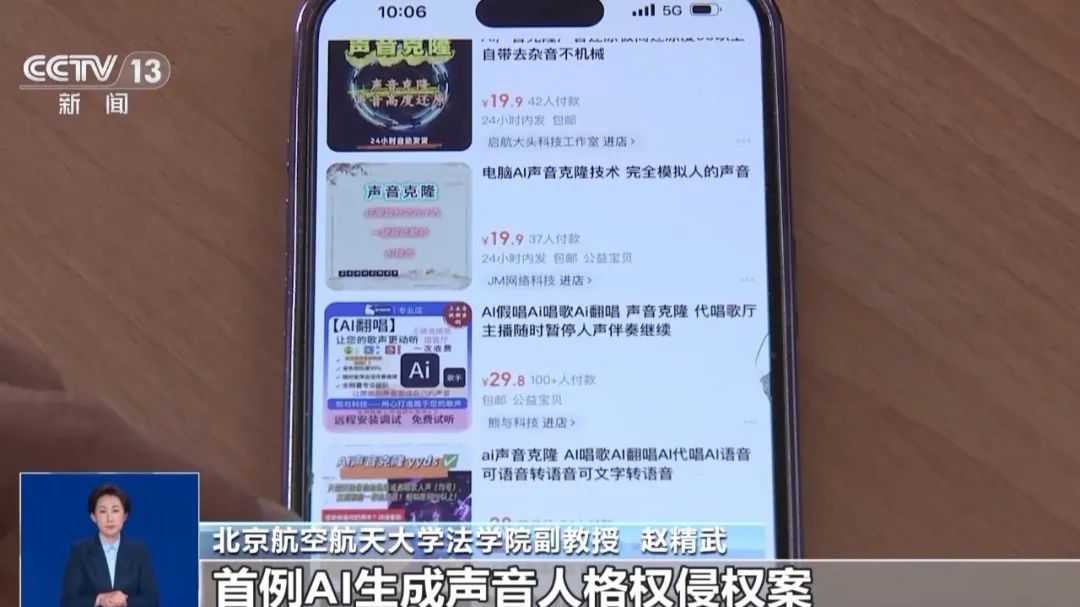

据央视新闻近日调查发现,实现AI深度合成音视频并不难,甚至在一些购物平台,AI深度合成技术已成为众多网店牟利的工具。花费几十元,即可定制AI深度合成的名人音视频。

网络主播直播教学

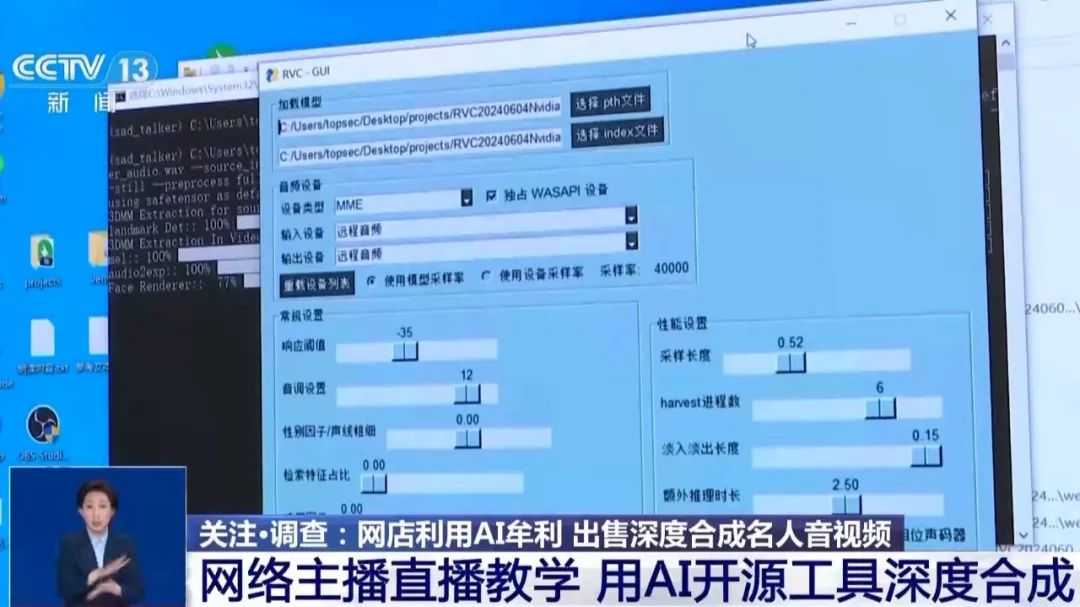

这些AI深度合成的声音和换脸是如何制作出来的?央视新闻记者调查发现,相应的深度合成软件在网络上下载不难,还有网络主播直播教学。

央视新闻记者在手机应用商城搜索换脸换声软件,发现众多工具,但逼真度不高。网店制作的逼真度高的AI深度合成声音和换脸又是如何做到的?中国网络空间安全协会专家表示,当前有很多开源软件和工具可实现换声换脸效果,但有一定的技术门槛。不过,仍有众多主播在教网民使用。

21世纪经济报道记者曾实测了一款个性化定制的文生音模型,198元即可定制角色,千元出头能定制6个角色,包括杨幂、刘亦菲等明星声音。

在使用上,瞬时克隆需上传5~8秒声音样本,专业克隆则需1分钟~60分钟训练素材。

未经授权合成制作他人视频声音属侵权

相关法律法规明确规定,未经授权,不得深度合成制作发布他人信息。网店接单AI深度合成制作名人视频,已属侵权行为,应承担法律责任。

北京航空航天大学法学院副教授赵精武表示,国内已审结首例AI生成声音人格权侵权案。在此案中,配音演员的声音被AI生成后对外出售,法院最终认定被告行为构成侵权。

不仅是名人,普通人甚至动画形象,若未经同意,用AI合成制作其音视频,也属侵权行为。

现代版“画皮”:AI换脸生成“爱情骗局”

去年10月,香港警方捣毁诈骗窝点,诈骗者利用深度伪造技术换脸成年轻女性,诱骗受害者投资虚拟货币,涉案金额超3.6亿港元。

联合国毒品和犯罪问题办公室报告指出,东南亚诈骗者利用生成式AI和深度伪造技术扩大诈骗规模。去年亚太地区深度伪造事件增1530%,暗网上深度伪造产品增600%以上。

在杀猪盘诈骗中,已有不少人遇到利用AI换脸的“盘哥”“盘姐”。国投智能首席科学家江汉祥分析,杀猪盘用AI视频换脸,真假难辨。

专家:可以用AI检测AI

中国网络空间安全协会专家指出,可利用AI技术对抗与检测AI。当前已有AI技术能检测图片或音视频是否后期加工合成。

天融信科技集团助理总裁张博提出三招识破套路:提高安全风险意识,在涉及敏感场景时保持警惕;接收视频信息时,观察细节是否自然;面临金融交易时,通过可靠方式确认对方身份。

法律专家提醒,法律没有灰色地带,AI深度合成制作和信息发布者切勿因小失大。赵精武强调,法律禁止不合法不合理的使用AI合成技术,尤其是禁止不标识、不提示的AI合成信息发布和传播。

(文章来源:21财经)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。