幻方量化DeepSeek-V3模型上线:性能强劲,API服务定价上调

AI导读:

幻方量化全新系列模型DeepSeek-V3上线并同步开源,API服务已同步更新,生成速度提升3倍,但暂不支持多模态输入输出。虽然API服务定价上调2倍有余,但DeepSeek-V3依旧极具性价比。

12月26日晚,量化投资领域的领先企业幻方量化宣布,其全新系列模型Deepseek-V3正式上线并同步开源,API服务也已同步更新,且接口配置无需改动。

自其上一代模型DeepSeek-V2.5于9月6日正式发布以来,幻方量化的迭代速度持续加快。

据介绍,DeepSeek-V3为幻方量化自研的MoE模型(Mixture of Experts,混合专家模型),在处理复杂任务时能够显著提高效率和精度。其生成速度相比V2.5模型实现了3倍的提升,但暂不支持多模态输入输出。

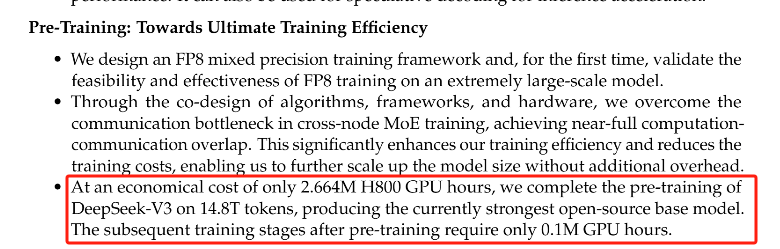

在参数和性能方面,DeepSeek-V3拥有6710亿参数,其中激活参数为370亿,在14.8万亿token上进行了预训练。每秒吞吐量高达60 token,进一步提升了模型的生成速度。

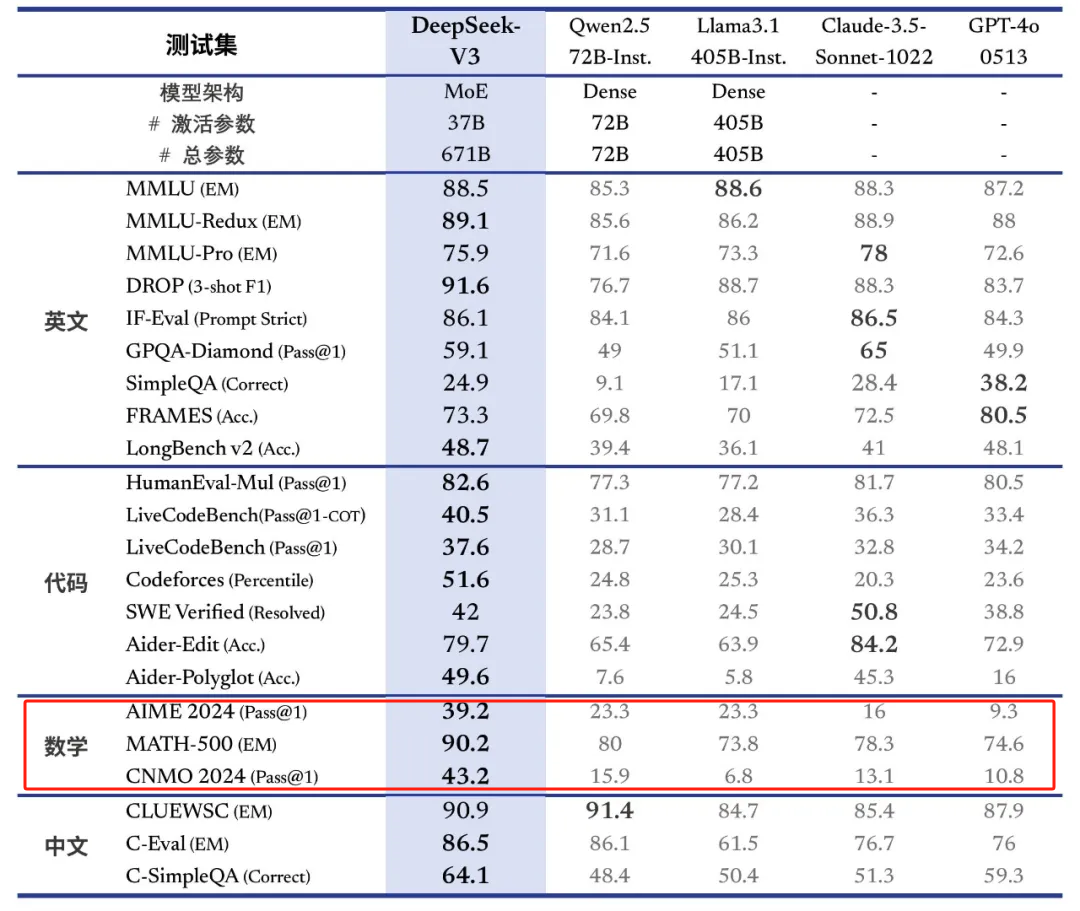

DeepSeek-V3完全开源,为开发者提供了更多选择和可能性。虽然当前版本暂不支持多模态输入输出,但在多语言处理方面表现出色,尤其在算法代码和数学方面。

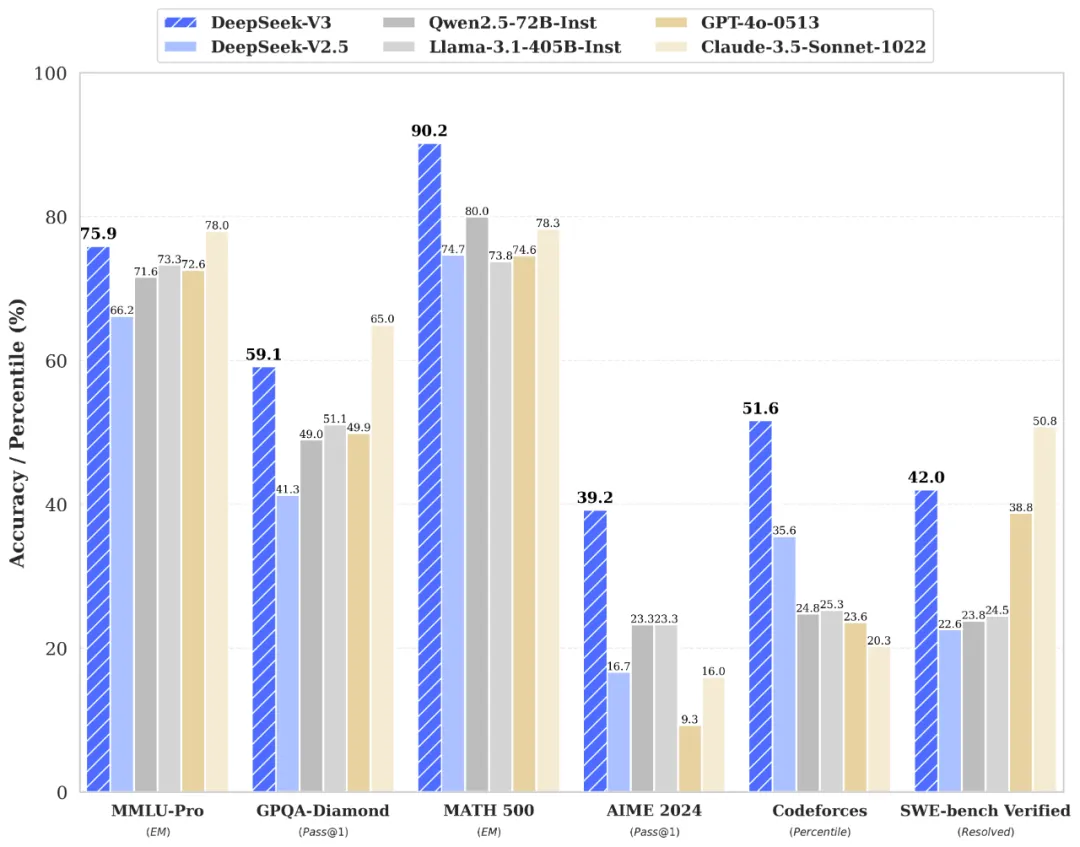

此外,DeepSeek-V3在多项基准测试中表现优异,成绩超越了Qwen2.5-72 B和Llama-3.1-405 B等其他开源模型,并在性能上和世界顶尖的闭源模型GPT-4o以及Claude-3.5-Sonnet不相上下。在数学能力方面,DeepSeek-V3更是大幅超过了所有开源闭源模型。

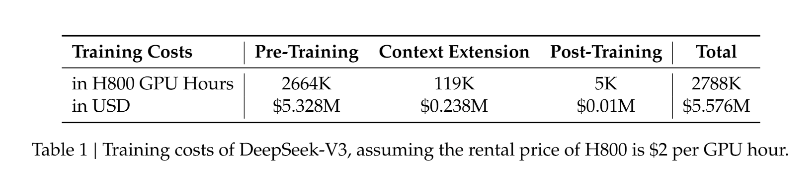

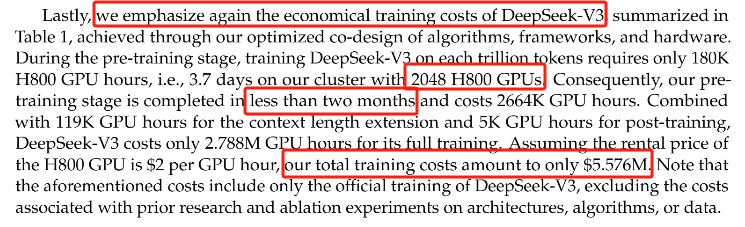

幻方量化在已开源的论文中强调,通过对算法、框架和硬件的优化协同设计,DeepSeek-V3的训练成本极低。假设H800GPU的租用价格为每块GPU2美元/小时,DeepSeek-V3的全部训练成本总计仅为557.6万美元。在预训练阶段,模型每训练1万亿token仅需要180K个GPU小时,即在配备2048个GPU的集群上只需3.7天,该阶段团队使用2048块H800 GPU训练了模型不到2个月便达成目标。

技术大牛Andrej Karpathy发文称赞道,要达到这种级别的能力,通常需要约1.6万个GPU的计算集群。DeepSeek-V3却只用了280万GPU小时(计算量减少了约11倍)。Stability AI前CEO也表示,以每秒60个token(相当于人类阅读速度5倍)的速度全天候运行DeepSeek-V3,每天仅需要2美元。

DeepSeek-V3的发布标志着DeepSeek AI在自然语言处理和AI领域的又一重要进步,预计将为开发者、企业和研究人员提供强大的工具和资源。其应用场景广泛,包括聊天和编码场景、多语言自动翻译以及图像生成和AI绘画等。

然而,值得注意的是,DeepSeek-V3的API服务定价上调为每百万输入tokens 0.5元(缓存命中)/2元(缓存未命中),每百万输出tokens 8元,按缓存未命中的输入价格计,加总成本是10元人民币,比上一代贵了2倍有余。尽管如此,与同类型模型相比,DeepSeek-V3依旧极具性价比。

(文章来源:财联社)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。