MiniMax发布M1模型,AI推理领域迎新突破

AI导读:

MiniMax发布了自主研发的M1系列模型,被誉为全球首个开源的大规模混合架构推理模型。M1在处理超长文本上实现突破,定价低于竞品,且推出超长文本档位。其独创的混合架构和CISPO算法显著提升计算效率和强化学习稳定性。

北京时间6月17日,AI领域备受瞩目的上海独角兽企业MiniMax,正式发布了其自主研发的MiniMax-M1系列模型。此次发布不仅带来了性能上的全面升级,更在价格上展现出竞争力,贝壳财经记者注意到,其定价低于Deepseek-R1,与近期降价的豆包1.6持平,引发业界广泛关注。

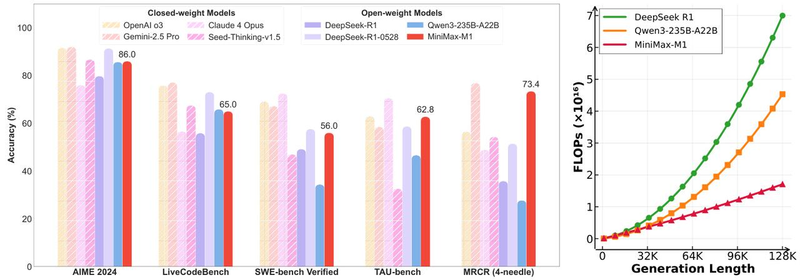

M1被誉为“全球首个开源的大规模混合架构推理模型”。据技术报告显示,M1在处理超长文本方面实现了重大突破,成为目前上下文最长的推理模型。其强化训练(RL)成本大幅下降,仅需53万美金,推理效率更是数倍于同类模型。在工具使用场景测试中,MiniMax-M1-40k更是领跑所有开源权重模型,超越Gemini-2.5 Pro。

MiniMax-M1开源技术报告截图

在定价策略上,M1模型针对不同输入区间设定了合理的价格。在0-32K范围内,输入价格为0.8元/百万Tokens,输出为8元/百万Tokens;32K-128K范围内,输入价格为1.2元/百万Tokens,输出为16元/百万Tokens。这一价格策略明显低于DeepSeek-R1,与火山引擎豆包1.6持平。值得注意的是,M1还推出了128K-1M的超长文本档位,填补了市场空白。

M1模型之所以能在长文本处理上取得突破,得益于其独创的Lightning Attention混合架构。传统Transformer模型在处理长序列时,注意力机制的计算量会随序列长度快速增长,成为性能瓶颈。而M1的混合架构,特别是其优化的注意力机制,显著提升了计算效率。

报告还提到,在深度推理任务中,M1所需的算力仅为DeepSeek-R1的约30%,生成10万tokens时算力需求更是仅为25%。这种算力效率的提升,直接转化为训练和推理阶段的成本优势。

此外,MiniMax还提出了创新的CISPO算法,通过裁剪重要性采样权重来提升强化学习的效率和稳定性。实验数据显示,CISPO的收敛性能优于字节跳动提出的DAPO算法和DeepSeek早期使用的GRPO算法。

得益于CISPO算法的高效,M1模型的强化学习阶段仅使用了512块英伟达H800 GPU,耗时三周,成本仅为53.5万美元,远低于预期。

MiniMax宣布,在其自有平台,M1模型将保持不限量免费使用。此次M1的发布标志着MiniMax“开源周”的开启,未来四天,MiniMax计划每天发布一项新技术或产品更新。

(文章来源:新京报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。