阿里巴巴开源视频生成编辑模型Wan2.1-VACE

AI导读:

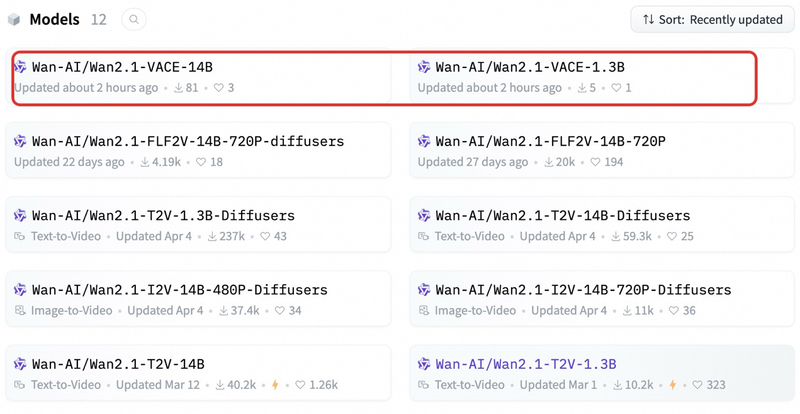

5月14日晚,阿里巴巴正式开源通义万相Wan2.1-VACE,这是业界功能最全的视频生成与编辑模型,支持文生视频、图像参考视频生成等全系列基础生成和编辑能力。本次共开源两个版本,标志着AI视频生成技术迈上新台阶。

5月14日晚,阿里巴巴正式开源通义万相Wan2.1-VACE,这是业界功能最全的视频生成与编辑模型,单一模型可同时支持文生视频、图像参考视频生成、视频重绘、视频局部编辑、视频背景延展以及视频时长延展等全系列基础生成和编辑能力。本次共开源1.3B和14B两个版本,其中1.3B版本可在消费级显卡运行,开发者可在GitHub、Huggingface及魔搭社区下载体验。该模型还将逐步在通义万相官网和阿里云百炼上线,标志着AI视频生成技术迈上新台阶。

据介绍,Wan2.1-VACE基于通义万相文生视频模型研发,创新性提出了全新的视频条件单元VCU,统一了文生视频、参考图生视频、视频生视频等4大类视频生成和编辑任务形态;同时,解决了多模态输入的token序列化难题,将VCU输入的帧序列进行概念解耦,分开重构成可变序列和不可变序列后进行编码。

Wan2.1-VACE支持全部主流输入形式,包括文本、图像、视频、Mask和控制信号,可实现角色一致性、布局、运动姿态和幅度等要素的控制。例如,基于物体参考图或视频帧生成视频,或通过抹除、局部扩展等操作重新生成原有视频,该模型还能通过深度图、光流、布局、灰度、线稿等控制信号对视频进行编辑。

Wan2.1-VACE支持任意基础能力的自由组合,无需针对特定功能训练新专家模型,即可完成复杂任务,极大扩展AI视频生成想象空间。例如,组合图片参考和主体重塑功能,实现视频物体替换;组合图片参考、首帧参考、背景扩展和时长延展功能,将竖版图片变为横版视频,并加入参考图片元素。

(文章来源:新京报,关键词:阿里巴巴、视频生成、AI技术、开源模型)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。