DeepSeek开源高效MLA解码内核,加速AI发展

AI导读:

DeepSeek启动“开源周”,开源首个针对Hopper GPU优化的MLA解码内核FlashMLA,旨在提高Transformer模型效率。同时,DeepSeek构建AGI小团队,计划开源5个代码库,加速行业发展。国内外头部厂商纷纷加码开源模型,AI Agent新形态即将到来。

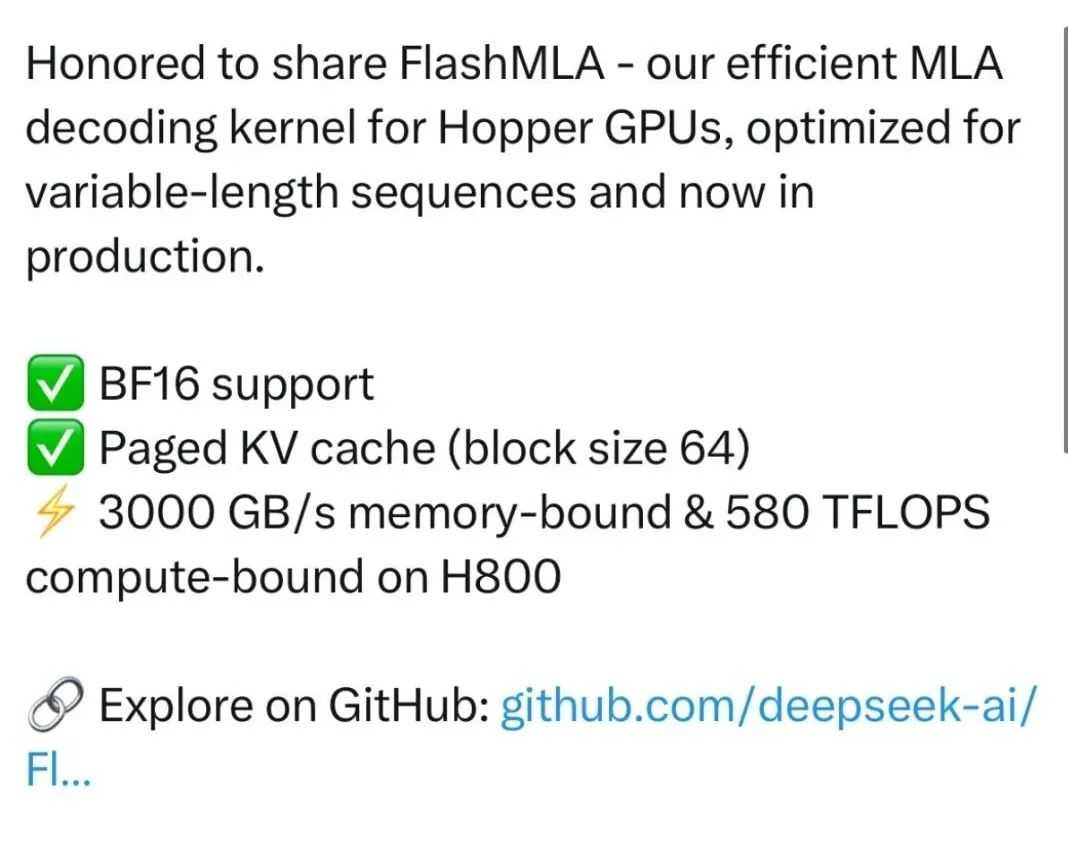

2月24日,Deepseek启动“开源周”,并开源了首个针对Hopper GPU优化的高效MLA解码内核FlashMLA,专为处理可变长度序列而设计,现已投入生产使用。DeepSeek表示,该内核在H800上能实现3000 GB/s的内存带宽以及580 TFLOPS的计算性能。

MLA(多层注意力机制)旨在提高Transformer模型在处理长序列时的效率和性能,通过多个头的并行计算,让模型能同时关注文本中不同位置和不同语义层面的信息,捕捉长距离依赖关系和复杂语义结构。

MLA(多层注意力机制)旨在提高Transformer模型在处理长序列时的效率和性能,通过多个头的并行计算,让模型能同时关注文本中不同位置和不同语义层面的信息,捕捉长距离依赖关系和复杂语义结构。

FlashMLA受到FlashAttention2&3和CUTLASS项目的启发。其中,FlashAttention能实现快速且内存高效的精确注意力;CUTLASS则是英伟达开发和维护的开源项目。

2月21日,DeepSeek宣布构建探索AGI(通用人工智能)的小团队,计划开源5个代码库,以透明方式分享研究进展。DeepSeek在线服务中的构建模块已记录、部署并测试,旨在加速行业发展。

上海开源信息技术协会秘书长朱其罡称:“开源技术正从代码共享迈向实体创新,成为推动智能未来的关键。中国开源生态的发展,如DeepSeek的成功,展现了从‘运营驱动’向‘价值驱动’的转变。”

2025年初,国内外头部厂商纷纷加码开源模型,豆包、昆仑万维、百度文心、阿里通义千问均推出开源模型。

在2025全球开发者先锋大会上,Minimax副总裁刘华表示:“底层模型的一次重大迭代,将远超工程实现层面的优化效果。当大模型达到专业人士水平,新的产品形态——AI Agent将到来,主动帮助人类解决问题,提高生产力。”

(文章来源:上海证券报)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。