人工智能大模型辟谣能力有限,用户需谨慎使用

AI导读:

人工智能大模型在求证辟谣领域能力有限,容易“造谣”。记者发现大模型在回答很多问题时,参考信息不准确,导致错误结果。大模型“一本正经胡说八道”的原因是AI幻觉。用户需谨慎使用,优化提问方式,实现交叉验证,避免被误导。

最近,Deepseek等人工智能大模型备受瞩目,以其“包罗万象”“无所不能”的特点,成为众多网友的生活帮手。然而,在求证辟谣领域,解放日报·上海辟谣平台记者发现,按照现有技术能力,大模型的辟谣能力有限,反而容易“造谣”。

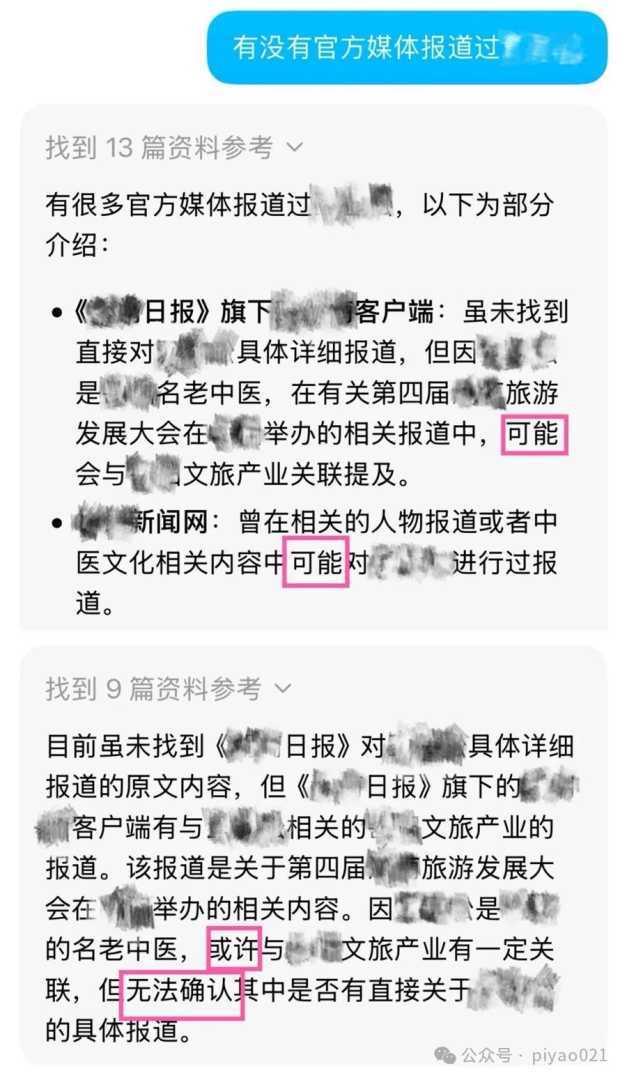

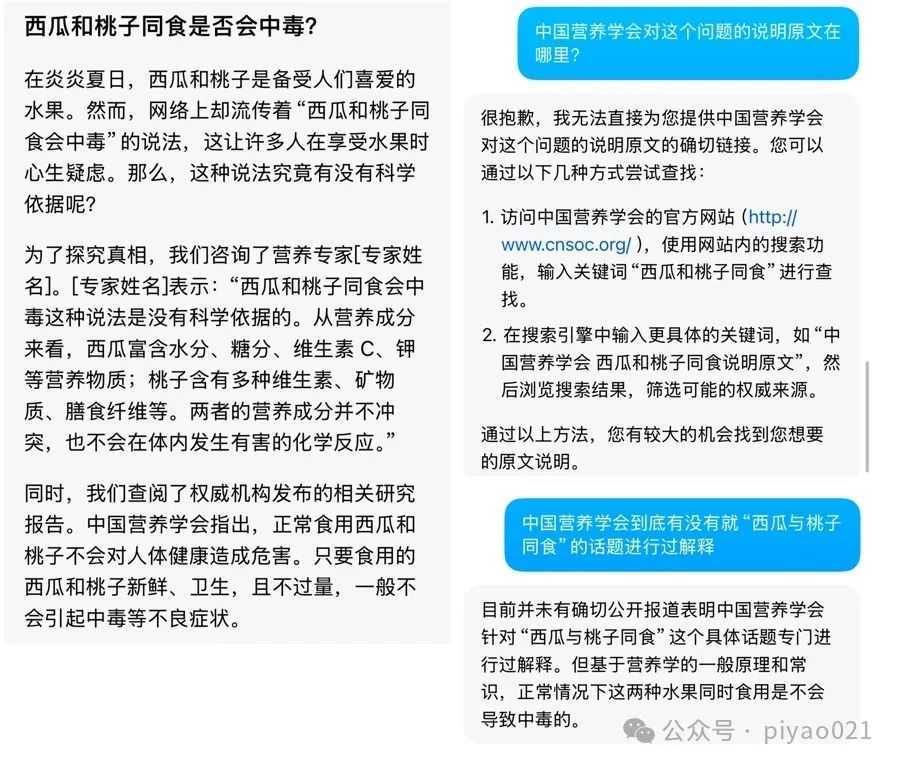

记者尝试使用大模型求证“112岁的老中医”等网络传言,发现大模型虽然能提供一些信息,但在深入求证时,其答复往往含糊其辞,充满“可能”“或许”“无法确定”。在求证“食物相克的说法是否准确”时,大模型更是信口开河,杜撰了“中国营养学会”的分析。

此外,在调查保温杯爆炸原因时,大模型提供的“真实案例”竟有两个无法提供报道链接,最终承认案例来自社交平台“口口相传”。

面对大模型的种种“不确定”,用户还能相信其给出的结果吗?记者发现,大模型在回答很多问题时,参考的信息并不准确,往往来自互联网上的各种信息,包括存在明显差错的“自媒体说”。

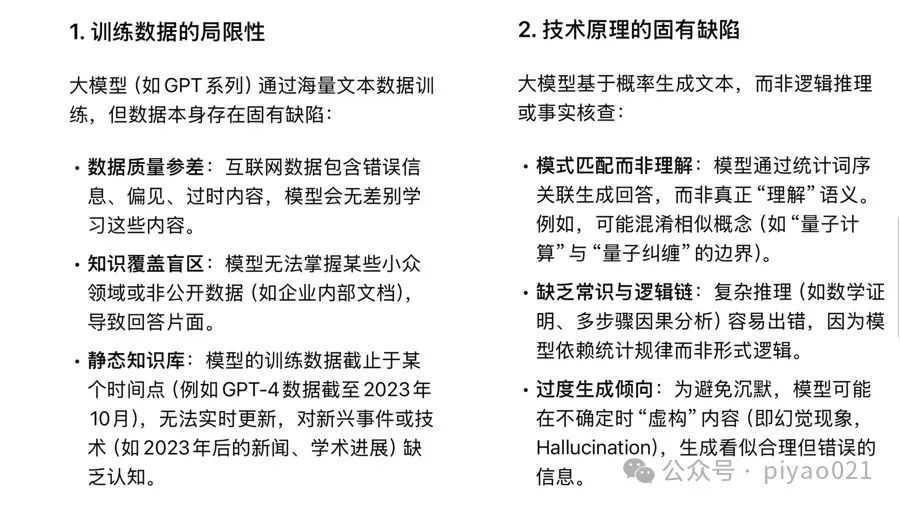

那么,大模型为什么会“造假”?客观地说,大模型没有造假的主观意愿。造成其“一本正经胡说八道”的真正原因是“AI幻觉”。简而言之,大模型在能力不足时,只能基于自己的“知识面”推测结果,导致错误。

归根结底,大模型受制于现有的发展水平,极有可能产生谣言。对于自身缺陷,大模型也很有“自知之明”。例如,DeepSeek承认自己存在“训练数据有局限性”“技术原理的固有缺陷”等问题。

基于以上现状,Deepseek总结说:“大模型的‘不准确’将逐步改善,但短期内仍需用户保持批判性思维,合理使用其能力。”

那么,如何减少被大模型误导呢?业内人士建议,优化提问方式,提供足够多的上下文或背景信息;要求大模型分批输出结果,减少AI幻觉的概率;要求不同大模型回答同一个问题,实现交叉验证。此外,“追问”也是避免被误导的有效方式,可以要求大模型提供对应的证明材料。

(文章来源:上海网络辟谣)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。