OpenAI遭遇数据瓶颈,Orion模型进展受阻

AI导读:

AI领头羊OpenAI在新模型Orion的推进中遭遇高质量数据不足的难题,直接影响AI模型改进速度。OpenAI正积极调整策略,探索新的AI模型改进方法,预计明年年初发布Orion模型。

AI领头羊OpenAI在新模型Orion的推进中遭遇了高质量数据不足的难题,这直接拖慢了AI模型的改进速度。

据OpenAI内部员工反馈,尽管Orion的性能超越了现有所有模型,但其性能提升幅度远不及GPT-3到GPT-4的飞跃。这表明,随着高质量数据的稀缺,AI模型的进步或将遭遇瓶颈。更为棘手的是,Orion在训练中采用了旧模型(如GPT-4及部分推理模型)生成的AI数据,这可能导致其复制旧模型的行为。

为应对这一挑战,OpenAI专门成立了“基础”团队,致力于在数据稀缺的背景下探索新的AI模型改进方法。公司计划通过AI合成数据来训练Orion,并在后续阶段实施更多优化措施。

目前,Orion正处于安全测试阶段,OpenAI预计将于明年年初发布该模型,并可能打破“GPT-X”的命名传统,以体现模型开发的变革。

此外,OpenAI今年收购了Chat.com域名,并已将其重定向至其AI驱动聊天机器人ChatGPT。

数据瓶颈凸显

早在2020年,OpenAI便提出了Scaling Law定律,指出大模型的性能主要取决于计算量、模型参数量和训练数据量,而非模型结构。这一理论一度被AI界广泛接受,但如今正面临越来越多的质疑。

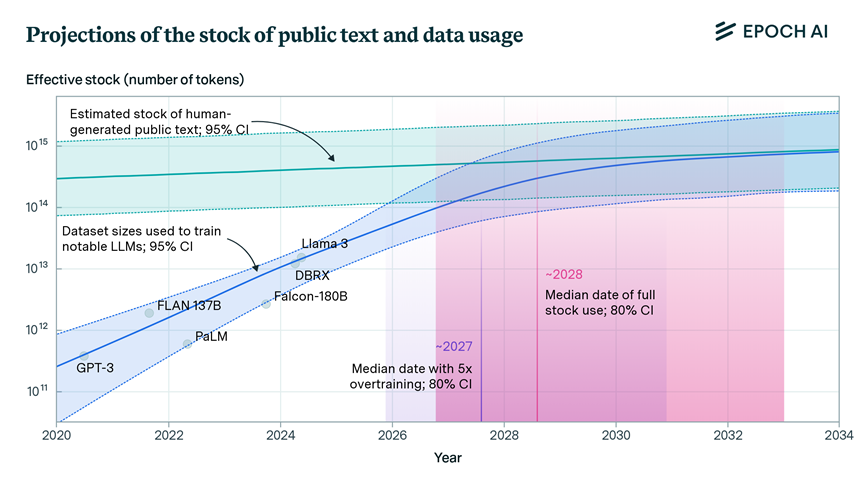

Meta AI人工智能研究院(FAIR)的田渊栋指出,随着模型性能接近人类水平,新数据的获取变得愈发困难,模型改进空间逐渐缩小,最终将难以解决某些边角案例。非营利研究机构Epoch AI的论文也预测,未来数年内,数据增长速度将无法支撑AI大模型的扩展,可能在2026至2032年间耗尽。

OpenAI并非首次面临数据资源短缺问题。此前在训练GPT-5时,就曾因文本数据不足而考虑使用YouTube公开视频转录文本。此次数据难题再度困扰OpenAI,甚至影响了新模型的研发进度。

然而,这并不意味着“天塌了”。The Information的作者Amir Efrati认为,OpenAI正在积极调整策略,或许将发现新的Scaling Law来取代旧理论。

值得注意的是,11月9日,OpenAI安全系统团队负责人翁荔(Lilian Weng)宣布离职,结束了近7年的OpenAI生涯。她在离职信中未透露具体原因及未来计划,仅表示将开启新的探索。

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。